PFCP の概要

Preferred Computing Platform™(PFCP™)は、Preferred Networks が構築・運用する深層学習・AI ワークロード向けのクラウドサービスです。独自開発したアクセラレータ MN-Core™ シリーズを唯一利用でき、高い AI 計算力と計算効率を実現できます。

強力な計算ボードと高速なネットワーク

MN-Core 2 ボードを 8 基搭載した MN-Server 2 V1 サーバを複数専有して利用できます。 すべてのノードは深層学習に最適化された高速なネットワークで相互に接続されています。

フルマネージドサービス

深層学習・AI ワークロード向けに拡張された Kubernetes クラスタ1をマルチテナントで利用できます。 大規模分散学習から推論サーバの高可用な運用まで幅広く機械学習ワークロードを実行できます。 ワークロードの状況を観測するためのマネージドなモニタリングサービス2も付随しています。

そのほかの特徴

- ユーザの権限管理、ネットワーク ACL の制御が柔軟に行えます

- 高信頼な永続ストレージを使用してデータを保存できます

- 多くの Kubernetes カスタムアドオンが追加されており、AI ワークロードの実行や監視をすぐに始められます

- コマンドラインツールを用いて、PFCP が提供するコンテナイメージを使用して任意のワークロード設定ファイルから実行できます

- ユーザが管理するコンテナイメージを持ち込んでの利用も可能です

- パブリッククラウドとの連携をサポートし、強い権限を持つ鍵を使用せずにパブリッククラウドのリソースを安全に利用できます

-

Kubernetes は、Cloud Native Computing Foundation(CNCF)にホストされたオープンソースのコンテナオーケストレーションプラットフォームです。コンテナ化されたアプリケーションの展開、スケーリング、可用性の管理を自動化するためのツールで、この分野の標準として広く採用されています。 ↩

-

Grafana、Prometheus、Alertmanager といったオープンソースのツールで構成されています。 ↩

用語集

PFCP で使用される用語について説明します。

組織

PFCP を利用する際に必要であり、Kubernetes クラスタの利用、ポータルの利用、認証認可などのベースとなるリソースです。 一般的にテナントと呼称されるものに相当します1。

PFCP を利用するには、利用したい組織から招待される必要があります。 また、Kubernetes クラスタやポータルなどの PFCP リソースを操作するときは、組織の選択が必要です。

1 つの組織で PFCP の複数クラスタが利用可能であり、複数の Namespace を作成できます。 Namespace 単位で権限分離・ネットワーク隔離も可能です。 このため、利用するリージョンごと・利用する用途ごとに、組織を細かく分割する必要はありません。

ルートネームスペース・サブネームスペース

PFCP では、各組織ごとに Namespace が 1 つ提供され、追加の Namespace はその Namespace に従属する Namespace として作成されます。 前者をルートネームスペース、後者をサブネームスペースと呼びます。 PFCP のネームスペースの詳細については、Namespace でクラスタを論理的に分割する をご確認ください。

ルートネームスペースとサブネームスペースは標準の Kubernetes クラスタにはない、PFCP 独自の用語です。 ルートネームスペースとサブネームスペースとでは仕様や扱い方が異なるため、区別する必要がある場合はこれらの呼称を使用しています。 一方で、Kubernetes の Namespace リソース全般にあてはまる記述であり、ルートネームスペースとサブネームスペースのどちらであるかを区別する必要がない場合は、 Namespace を使用しています。

ユーザロール(組織管理者・一般ユーザ)

PFCP には、組織管理者・一般ユーザの 2 種類のロールが定義されています。 ロールの詳細や利用できる操作については、PFCP のロール をご確認ください。

一方、Kubernetes には RBAC2 を実現するために Role/ClusterRole リソースがあります。 PFCP でも標準の ClusterRole3 が提供されていますが、この ClusterRole と PFCP のユーザロールは一対一でマッピングされません4。 組織管理者が RoleBinding を作成することで、Namespace ごとにマッピングを変更できます。

一般ユーザのユーザを個別に対象とする RoleBinding を作成することも、ユーザをグループにまとめ、グループを対象に RoleBinding を作成することも可能です。

RoleBinding の詳細については、 ユーザのクラスタアクセス権限を管理する をご確認ください。 ユーザ管理の詳細については、 組織のユーザを管理する をご確認ください。

モニタリングサービス

PFCP でマネージドサービスとして提供している、Grafana、Prometheus、Alertmanager の総称です。

Identity-Aware Proxy(IAP)

PFCP で提供している、ワークロードをインターネットに公開するための仕組みです。 アクセス時の認証が自動で設定されるため、ワークロードを安全に公開できます。

認証方式の違いにより API Identity-Aware Proxy(API IAP)と WebApp Identity-Aware Proxy(WebApp IAP)の 2 つに分かれています。 詳細な使い方は ワークロードをウェブ API として公開する または ワークロードをウェブアプリとして公開する を参照してください。

-

Google Cloud のプロジェクト、Amazon Web Service のアカウントとも近い概念です。 ↩

-

Role Based Access Control ↩

-

org-admin、org-edit、org-viewの 3 つが提供されています。 ↩ -

組織管理者に限り、ルートネームスペースとすべてのサブネームスペースで

org-adminにマッピングされます。 ↩

PFCP リリースノート

2025年11月

PFCP: Ingress の公開範囲を組織の一部ユーザへ限定できるようになりました(お知らせ)

Kubernetes: 分散バッチ処理を実行するための ParallelJob カスタムリソースが利用可能になりました(ドキュメント)

Kubernetes: 共有ノードで永続ストレージにファイルシステムが利用可能になりました

Kubernetes: 脆弱性対応のために runc バージョンを v1.3.3 に更新しました(お知らせ)

2025年10月

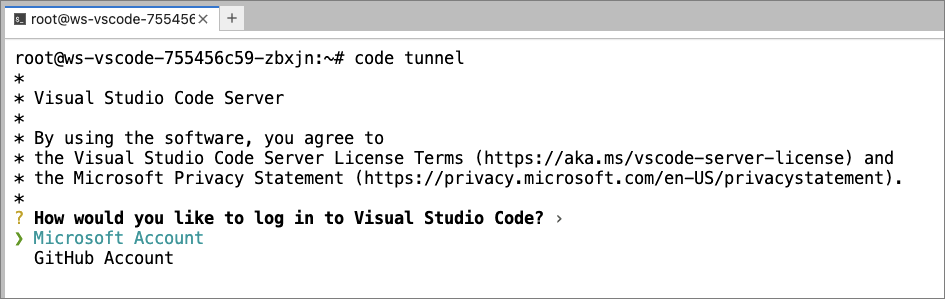

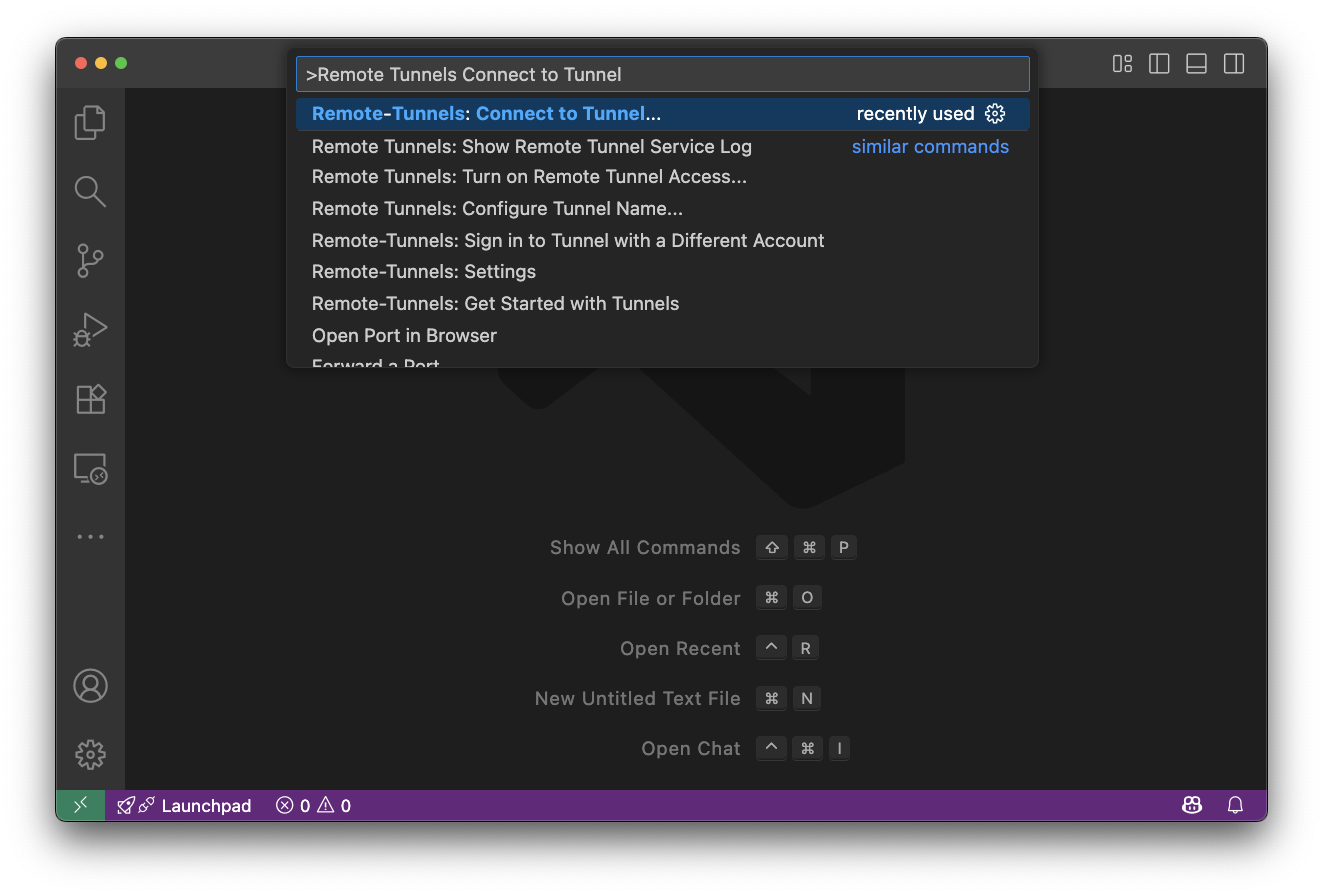

PFCP: ワークスペースにお手もとの Visual Studio Code から接続できるようになりました(ドキュメント)

2025年9月

Kubernetes: KEDA を利用した外部イベント駆動によるワークロードの自動水平スケーリングが利用可能になりました(ドキュメント)

2025年8月

Kubernetes: 永続ストレージのスナップショット機能が利用可能になりました(ドキュメント)

2025年7月

AlertmanagerConfig カスタムリソースを作成しても Alertmanager に設定が反映されていなかった問題を修正しました

PFCP: ワークスペースの構成を事前に定義して共有できる「プリセット」機能が利用可能になりました(ドキュメント)

PFCP: ワークロードをウェブ API として公開する “API Identity-Aware Proxy” 機能が利用可能になりました(ドキュメント)

2025年6月

Kubernetes: 全拠点の全てのクラスタで Kubernetes v1.32 へのアップグレードを実施しました(ドキュメント)

2025年5月

Kubernetes: 共有ノード用に

shared-standardとshared-best-effortの 2 つの PriorityClass が追加されました(ドキュメント)PFCP: PFCP ポータルからワークスペースを作成する際に Pod の PriorityClass が選択可能になりました

2025年4月

MN-Core: MN-Core SDK v0.2 がリリースされました(更新内容はコンテナイメージ内の

/opt/pfn/pfcomp/RELEASE_NOTES.mdをご参照ください)Kubernetes: 新しい計算ノードの種類として「共有ノード」が利用可能になりました(ドキュメント)

Kubernetes: ワークスペース内の PersistentVolume を残したまま計算リソースを節約する「ワークスペース休止」機能が利用可能になりました(ドキュメント)

2025年3月

PFCP: PFCP ポータルにおいて PFCP 提供コンテナイメージの一覧が閲覧可能になりました(ドキュメント)

2025年2月

Kubernetes: ブラウザから使えるインタラクティブな作業環境を提供する「ワークスペース」機能が利用可能になりました(ドキュメント)

Kubernetes: 全拠点の全てのクラスタで Kubernetes v1.31 へのアップグレードを実施しました(ドキュメント)

Kubernetes: 組織管理者が Kubernetes Role リソースの操作が可能になりました(ドキュメント)

2024年12月

Kubernetes: PFCP ポータルにおいて組織で利用可能な専有ノードの一覧が閲覧可能になりました

PFCP: 組織に属するユーザをグループにまとめる「ユーザグループ」機能が利用可能になりました(ドキュメント)

2024年11月

Kubernetes: 全拠点の全てのクラスタにおいて GitOps ツールの Flux が利用可能になりました(ドキュメント)

2024年10月

Kubernetes: SR1-01 クラスタの永続化ストレージにおいて同一組織内の Namespace であればファイルストレージが共有できるようになりました(ドキュメント)

2024年9月

Kubernetes: 全拠点の全てのクラスタで Kubernetes v1.30 へのアップグレードを実施しました(ドキュメント)

2024年6月

Kubernetes: SR1-01 クラスタで永続ストレージが利用可能になりました(ドキュメント: ファイルストレージを使用する、ブロックストレージを使用する)

Kubernetes: 組織で利用可能な専有ノードの情報を

kubectl get reservednodeコマンドで確認可能になりました(ドキュメント)Kubernetes: 全拠点の全てのクラスタで Kubernetes v1.29 へのアップグレードを実施しました(ドキュメント)

2024年4月

メンテナンスポリシ

計画メンテナンスおよび緊急メンテナンスのポリシについて説明します。

定期メンテナンスのポリシ

PFCP では信頼性を維持するために定期的な計画メンテナンスを実施します。

| 項目 | 内容 |

|---|---|

| 実施日 | 毎月第一月曜日 |

| 実施日の告知 | 実施予定の1か月前まで (第一月曜日から変更がある場合のみ告知) |

| 実施内容の告知 | 実施日の2週間前まで (メンテナンスを実施する場合のみ告知) |

Kubernetes バージョンのアップグレードのポリシ

Kubernetes クラスタの安定性、パフォーマンス、セキュリティの向上を目的にマイナーバージョンアップグレードを定期的に実施しています。

| 項目 | 内容 |

|---|---|

| 実施頻度 | 4ヶ月毎 |

| 採用するバージョン | 最新のマイナーバージョンから1つ前のマイナーバージョン (例: 最新が v1.30 の場合、採用するバージョンは v1.29) |

| 実施日の告知 | 定期メンテナンスの実施内容として告知 |

アップグレードおよびその他メンテナンスのクラスタとワークロードへの影響

クラスタアップグレードなどの計算ノードの一時的な停止を伴うメンテナンスのユーザ影響を説明します。

クラスタと計算ノードへの影響

- クラスタの操作が一時的に不安定になります

- ユーザ割り当ての専有ノードのうち、アップグレード実施中の計算ノードが一時的に使用できなくなります

- 専有ノードの契約台数が 4 台未満の場合は 1 台ずつ、4 台以上の場合は最大 25%(小数切り捨て)が一時的に使用できなくなります

- 1 台のみ契約されている場合は一時的に利用できるノードがなくなります

- 共有ノードは 25%(小数切り捨て)が一時的に使用できなくなります

ワークロードへの影響

- 計算ノードのアップグレード実施に伴い該当ノードで実行中のワークロード(Kubernetes Pod)は削除されます

- 削除されたワークロードは、再スケジューリングポリシに基づき、別の計算ノードまたは同ノードで自動的に再作成されます

- Deployment や Job などの上位リソースを使わずにユーザにより直接作成された Pod(Bare Pod)は自動的に再作成されません

- 直接 Pod リソースを作成することは避けることを推奨します

Warning

データ保持に関する注意点

- ワークロードが保持するデータのうち、永続ストレージに保存されていないデータは失われることに注意してください

- ローカルメモリ上のデータ、一時的なファイルシステム上のデータなど

- 永続ストレージに保存されているデータは保持されます

計算ノードのメンテナンス実施に備えて推奨される対応

- 計算結果や生成物などの重要なデータは必ず永続ストレージに保存してください

- ワークロードがステートフルな場合は、データの永続化および復旧手順を十分に検討・準備してください

Important

メンテナンスや障害以外にもあらゆる理由でワークロード、プロセスは停止します。重要なデータは必ず永続ストレージに保存してください。

緊急メンテナンスのポリシ

サービスの提供継続が困難またはセキュリティ上の重大な脆弱性が発見されたなどの理由から予定されていないメンテナンスを実施することがあります。 クラスタおよび計算ノード、ワークロードに影響がある場合には事前に実施内容を告知します。

メンテナンス情報を入手する

新しいメンテナンス情報は PFCP お知らせサイト に掲載します。 詳しくは新機能・メンテナンスの通知を参照ください。

計算ノードの障害復旧ポリシ

計算ノードで障害が発生した場合の復旧ポリシについて説明します。

計算ノードの障害

計算ノードが正常に動作していないと判断した場合に障害が発生したとして復旧対応を実施します。下記は正常に動作していないと判断する一例です。

- 計算ノードが搭載するデバイスの一部が機能していない

- 計算ノードとの通信が確立できない

計算ノードの障害復旧ポリシ

計算ノードで障害が発生したと判断した場合には下記のポリシに基づき復旧対応を実施します。

- ユーザへの事前の告知なしに該当計算ノード上のワークロード(Kubernetes Pod)を削除し、計算ノードを再起動します

- 削除されたワークロードは、再スケジューリングポリシに基づき、別の計算ノードまたは同ノードで自動的に再作成されます

- Deployment や Job などの上位リソースを使わずにユーザにより直接作成された Pod(Bare Pod)は自動的に再作成されません

- 直接 Pod リソースを作成することは避けることを推奨します

- 削除されたワークロードは、再スケジューリングポリシに基づき、別の計算ノードまたは同ノードで自動的に再作成されます

- 専有ノードの場合に再起動で復旧が見込めない場合には代替の計算ノードとの入れ替えを行います

計算ノードの障害に備えて推奨される対応

- 計算結果や生成物などの重要なデータは必ず永続ストレージに保存してください

- ワークロードがステートフルな場合は、データの永続化および復旧手順を十分に検討・準備してください

Important

メンテナンスや障害以外にもあらゆる理由でワークロード、プロセスは停止します。重要なデータは必ず永続ストレージに保存してください。

新機能・メンテナンス情報を入手する

PFCP の新しい機能追加・メンテナンスに関する最新情報を入手する方法について説明します。

お知らせサイト

ウェブサイトに最新情報を掲載しています。

RSS リーダを使用して新着情報を購読する

お知らせサイトは RSS フィードを発行しています。RSS リーダを使用して新着情報を購読できます。

- 全カテゴリ: https://pfcomputing.com/news/index.xml

- カテゴリ別

Slack チャンネルで購読するには Add RSS feeds to Slack | Slack を参照ください。

メーリングリスト

準備中です。

PFCP チュートリアル: ワークロードをデプロイする

このページでは、クラスタを使用してサーバのワークロードのデプロイを行い、モニタリングサービスの使用方法を学びます。

事前準備

左カラム「クラスタに接続する」の手順を実行して下記を完了してください。

- PFCP ポータルにログインできている

- クラスタへの接続が構成できている

Namespace の作成

本チュートリアルで使用する Namespace1 を作成します。

Note

Namespace の作成には「組織管理者」の権限が必要です。「一般ユーザ」の権限では Namespace の作成に失敗します。

一般ユーザでの操作の場合は、組織の組織管理者に対して Namespace の作成を依頼してください。

-

ポータルのネームスペースにアクセスします。

-

ネームスペースの作成 画面を開きます。

- クラスタ名: 利用するクラスタを選択

- ネームスペース名:

org-<組織名>--<任意の値>2

-

作成 ボタンをクリックすると、Namespace が作成されます。

-

kubectl コマンド実行時のデフォルトの Namespace として、作成した Namespace を設定します。

$ kubectl config set-context --current --namespace=<作成したNamespace名> -

Namespace が作成されていること、設定が正しいことを確認します。

kubectl get podを実行してください。エラーが出なければ正しく設定されています。エラーが出力された場合は、Namespace が存在することを確認のうえ、実行コマンドが正しいかを再度確認してください。// 正しく設定されている場合 $ kubectl get pod No resources found in <作成したNamespace名> namespace. // 設定に誤りがある場合 $ kubectl get pod Error from server (Forbidden): pods is forbidden: User "oidc:org-<組織名>/<ユーザ名>" cannot list resource "pods" in API group "" in the namespace "<作成したNamespace名>"

ワークロードのデプロイ

PFCP の Kubernetes クラスタを用いて、サンプルの Pod を実行します3。 加えて、作成した Pod をインターネットに対して公開し、ブラウザからアクセスできることを確認します。

なお、サンプルのコンテナイメージとして podinfo を使用しています。

-

以下のコマンドを実行し、podinfo を実行する Deployment を作成します。

$ kubectl create deployment podinfo --image=stefanprodan/podinfo --port=9898 deployment.apps/podinfo created -

Pod の起動を確認します。

$ kubectl get pod NAME READY STATUS RESTARTS AGE podinfo-554c877494-p58gf 1/1 Running 0 25s -

次に、起動した Pod を公開するための Service を作成します。

$ cat << EOF | kubectl apply -f - apiVersion: v1 kind: Service metadata: labels: app: podinfo name: podinfo spec: ports: - name: http port: 8080 protocol: TCP targetPort: 9898 selector: app: podinfo EOF service/podinfo created $ kubectl get service NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE podinfo ClusterIP 10.100.212.250 <none> 8080/TCP 77s -

作成された Service をインターネット公開するために、Ingress を作成します。

$ HOST=podinfo-<任意の名前>.<組織名>.sr1-01.ingress.pfcomputing.com $ kubectl create ingress podinfo-ingress --class=nginx --rule="${HOST}/*=podinfo:8080" ingress.networking.k8s.io/podinfo-ingress created $ kubectl get ingress NAME CLASS HOSTS ... podinfo-ingress nginx <HOSTと同じ値> ... -

ブラウザから

https://<HOSTと同じ値>にアクセスします。podinfo の画面が表示されたら成功です。

モニタリングの確認

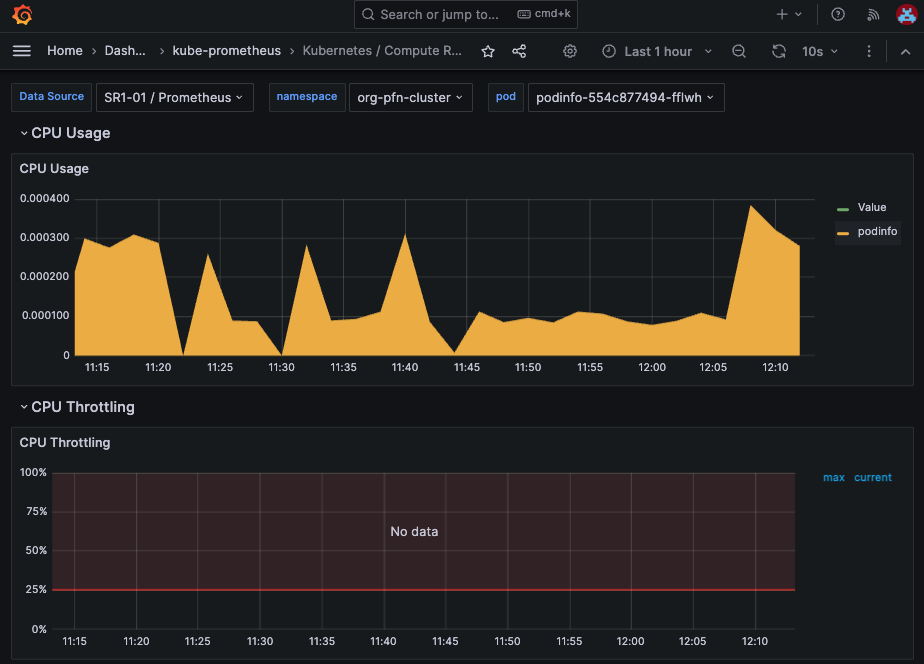

PFCP では、Grafana と Prometheus がマネージドサービスとして提供されています。 これらを使用して、作成した Pod のリソース仕様状況を確認します。

-

Grafana のダッシュボードにアクセスします。ポータルのトップページ に表示されているリンクからアクセスできます。

-

左上のハンバーガーアイコンから

Dashboards>kube-prometheus>Kubernetes / Compute Resources / Podと辿ることで、Pod のリソース使用状況を確認できます。 Namespace 及び Pod 名は適切なものをプルダウンで選択します。以下のような画面が確認できます。

-

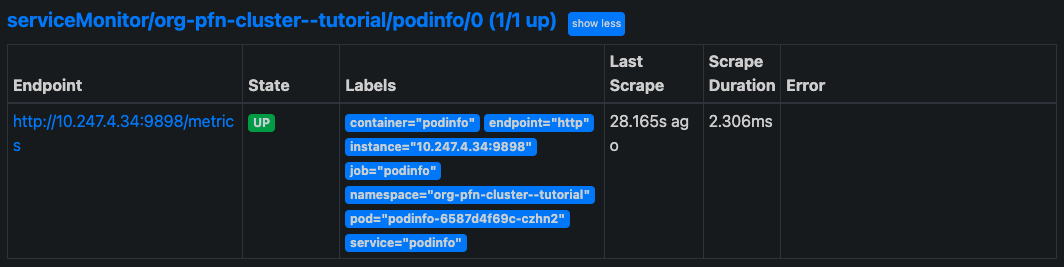

Pod で計装されているメトリックについても、Prometheus による収集と Grafana による可視化が可能です。 例として、上記で作成した podinfo Pod のメトリック4を収集します。

以下のServiceMonitorカスタムリソースを作成します。

$ cat << EOF | kubectl apply -f - apiVersion: monitoring.coreos.com/v1 kind: ServiceMonitor metadata: name: podinfo spec: selector: matchLabels: app: podinfo endpoints: - interval: 30s port: http path: /metrics EOF servicemonitor.monitoring.coreos.com/podinfo created -

podinfo のスクレイプに成功し、メトリックの収集ができていることを確認します。 Prometheus の WebUI にアクセスし、 上部のタブから

Status>Targetsを選択します。<作成したNamespace名>/podinfo/0がターゲット一覧に表示され、ステータスがUpになっていれば、正しくスクレイプできています。

-

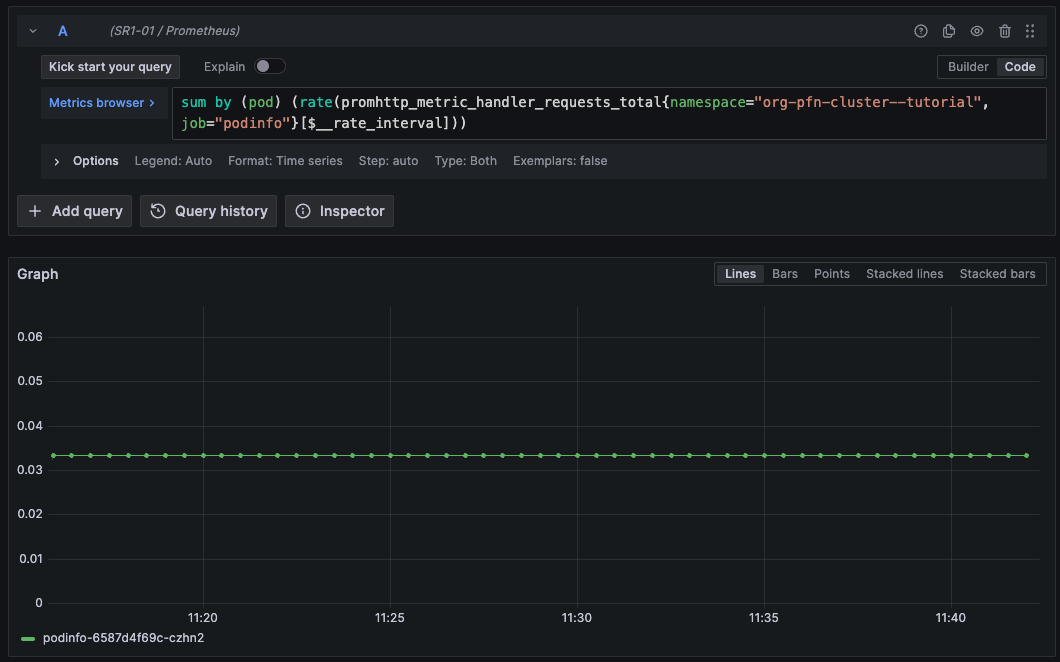

収集したメトリックは、Grafana で可視化できます。 Grafana のダッシュボードを開き、左上のハンバーガーアイコンから

Exploreを選択します。 例として以下の PromQL クエリを実行すると、/metricsendpoint がコールされた回数が時系列表示されます。sum by (pod) (rate(promhttp_metric_handler_requests_total{namespace="<作成したNamespace>", job="podinfo"}[$__rate_interval]))

-

作成した Namespace は、PFCP ではサブネームスペースとして扱われます。詳しくは 用語集 をご確認ください。 ↩

-

作成済の Namespace と異なる接尾辞をつける必要があります。複数人でチュートリアルを実施する場合は、ユーザ名の使用を推奨します。 ↩

-

podinfoは、

/metricsでPrometheus用のメトリックを提供しています。 ↩

PFCP チュートリアル: MN-Core を PyTorch から使用する

このドキュメントでは、MLSDK(Machine Learning Software Development Kit)を使用して MN-Core を使用する方法を説明します。

MLSDK とは

MLSDK は、PyTorch から MN-Core を使用できるようにするためのコンパイラ、ランタイムソフトウェアスタック、ドキュメントを含むソフトウェア開発環境です。 名前に「Machine Learning(ML)」とありますが、機械学習分野以外の高速な計算処理を行うソフトウェアの開発にも使用できます。

環境を構築する

インタラクティブな作業環境をクラスタ上に作成する「ワークスペース」機能を使用して環境を構築します。

- ポータルの ワークスペースページ にアクセスし、新規作成 ボタンをクリックします

- フォームを入力し、作成 ボタンをクリックします

| 項目名 | 値 |

|---|---|

| ネームスペース | 組織のルートネームスペースを選択してください |

| ワークスペース名 | 任意の名前を入力してください |

| 所有者 | 個人ごとに隔離 |

| プリセット | default |

| 優先度クラス | (unspecified)(専有ノードを使用)共有ノードを使用する場合は shared-best-effort を選択ください |

| CPU | 7000m |

| Memory | 125Gi |

| MN-Core 2 | 1 |

Note

永続ストレージを追加する

永続ストレージをマウントしていないパスに配置されたファイルの変更は、永続化されずに失われてしまいます。 変更を永続化する際は、「永続ストレージを追加」から新規ストレージを払い出し、

/dataなどにマウントしてファイルを保存してください。

環境にアクセスする

作成したワークスペースの URL 列にあるリンクをクリックして作業環境(JupyterLab)にアクセスします。

Note

ワークスペースの作成には時間がかかる場合があります。

しばらく時間が経過しても作成が完了しない場合はフォームで入力した値が間違っていた可能性があります。もう一度やり直してみてください。

JupyterLab の「Launcher → Other / Terminal」のボタンをクリックし、ターミナルを開きます。

ターミナル上で次のコマンドを実行して環境に接続された MN-Core 2 デバイスを確認できます(割り当てられたデバイスによって異なる値が出力されます)。

$ gpfn3-smi list

0: mnc2p28s0

何も表示されない場合は、ワークスペースの構成に間違いがないかどうか再確認してください。

MLSDK チュートリアルを開始する

MLSDK で MN-Core を使用する (英語) を参照してチュートリアルを開始します。

MLSDK チュートリアルのドキュメントは、コンテナイメージにも同梱されていますので、そちらでも参照できます。

$ cat /opt/pfn/pfcomp/codegen/MLSDK/README.md

環境を削除する

使用が終了した環境はポータルページで削除します。

- ポータルの ワークスペースページ にアクセスします

- 削除するワークスペースの ⋯ ボタンから「削除」をクリックします

PFCP チュートリアル: クラウドストレージのデータをクラスタに取り込む

このページでは、クラウドストレージにあるデータを PFCP に持ち込むための手順を解説します。

ここでは一例として、ユーザが管理する AWS S3 に保存されているデータを PFCP 上の Persistent Volume にコピーします。

事前準備

左カラム「クラスタに接続する」の手順を実行して下記を完了してください。

- PFCP ポータルにログインできている

- クラスタへの接続が構成できている

また、AWS アカウントと、データを同期させる対象の S3 バケットが必要です1。

パブリッククラウドと ID 連携を構成し、データをコピーする

AWS 側の設定

ここでは sr1-01 拠点を利用している場合の設定を説明します。他の拠点を利用している場合はドメイン名等を適宜読み替えてください。

-

アクセスしたい AWS アカウント内に OIDC プロバイダを作成します2。

- プロバイダ(発行者)URL は 拠点と計算ノード を参照してください。

- 許可するオーディエンス:

sts.amazonaws.com

-

AWS へのアクセスに使用する IAM ロールを作成します。この IAM ロールは、ID 連携により Kubernetes ServiceAccount に紐づけて使用します。 ここでは

data-transfer-sr1-01という IAM ロールを作成します。 -

ID 連携による紐づけを許可するために、IAM ロールを引き受けさせる Kubernetes ServiceAccount を指定して、以下のような信頼ポリシを構成します3。 ServiceAccount は、既存のものを指定するか、後ほど新たに作成します。ここでは

data-transfer-saという ServiceAccount を作成します。{ "Version": "2012-10-17", "Statement": [{ "Sid": "", "Effect": "Allow", "Principal": { // 前のステップで作成した oidc provider の ARN を指定します。 "Federated": "arn:aws:iam::{aws_account_id}:oidc-provider/token.sr1-01.kubernetes.pfcomputing.com" }, "Action": "sts:AssumeRoleWithWebIdentity", "Condition": { "StringEquals": { // このIAMロールを引き受けさせる Kubernetes ServiceAccount 名を指定します。 "token.sr1-01.kubernetes.pfcomputing.com:sub": "system:serviceaccount:<namespace>:data-transfer-sa" } } }] } -

転送したいデータを含んだ S3 のバケットに、特定の IAM ロールからアクセス可能にするポリシを設定します4。

{ "Version": "2012-10-17", "Statement": [ { "Effect": "Allow", "Principal": { "AWS": "arn:aws:iam::{aws_account_id}:role/data-transfer-sr1-01" }, "Action": [ "s3:ListBucket", "s3:GetObject", ], "Resource": [ "arn:aws:s3:::example-bucket", "arn:aws:s3:::example-bucket/*" ] } ] }

Kubernetes クラスタ側の操作

-

ServiceAccount を作成します。データコピーに利用する ServiceAccount の annotations に、S3 のバケットにアクセス可能な AWS IAM ロール

data-transfer-sr1-01を指定します。apiVersion: v1 kind: ServiceAccount metadata: name: data-transfer-sa annotations: aws.id-federation.preferred.jp/role-arn: "arn:aws:iam::{aws_account_id}:role/data-transfer-sr1-01" -

ID 連携が正常に動作していることを確認します。Pod を作成する際に、

spec.serviceAccountNameにこの ServiceAccount を指定します。 Pod には 1 時間が有効期限である AWS のセッショントークンが自動的に設定されます。有効期限が到来すると、AWS SDK は更新されたトークンを自動で読み込み直します。aws sts get-caller-identityコマンドを実行し、セッショントークンが ServiceAccount に紐づいた AWS IAM Role へ AssumeRole できることを確認します。$ kubectl run --rm --overrides='{"spec":{"serviceAccountName": "data-transfer-sa"}}' id-federation-check --image=amazon/aws-cli -- sts get-caller-identity { "UserId": "***********************:botocore-session-1751604047", "Account": "{aws_account_id}", "Arn": "arn:aws:sts::{aws_account_id}:assumed-role/data-transfer-sr1-01/botocore-session-1751604047" } -

データを格納するための永続ストレージ(Persistent Volume Claim、 PVC)を作成します5。

apiVersion: v1 kind: PersistentVolumeClaim metadata: name: data-transfer-pvc spec: resources: requests: storage: 10Gi storageClassName: standard-rwx-<組織名> -

AWS CLI の

s3 syncコマンドでデータをコピーする Job を作成します。 上記で作成した PVC をマウントし、template.spec.serviceAccountNameに、 AWS との ID 連携を有効にしたdata-transfer-saを指定します。<バケット名>、<オブジェクト名>は適切に変更してください。apiVersion: batch/v1 kind: Job metadata: name: data-transfer-job spec: template: spec: serviceAccountName: data-transfer-sa # ID 連携を構成した ServiceAccount を指定 containers: - name: transfer image: amazon/aws-cli command: ["aws"] args: ["s3", "sync", "s3://<バケット名>/<オブジェクト名>", "/mnt/data"] volumeMounts: - mountPath: "/mnt/data" name: my-volume volumes: - name: my-volume persistentVolumeClaim: claimName: data-transfer-pvc restartPolicy: OnFailurekubectl logs job/data-transger-jobを実行し、コマンドが正常に終了していることを確認します。$ kubectl logs job/data-transger-job download: s3://<バケット名>/file1.txt to /mnt/data/file1.txt ... Completed 10 of 10 file(s), 100% done.

クリーンアップ

チュートリアルで作成したリソースをすべて削除します。

kubectl delete job/data-transfer-job

kubectl delete pvc/data-transfer-pvc

kubectl delete serviceaccount/data-transfer-sa

必要に応じて、 AWS 側のリソースも削除します。

Note

A brand-new MLSDK document is available at:

- English: https://pfcomputing.com/mlsdk/en/

- Japanese: https://pfcomputing.com/mlsdk/ja/

Note

This document is based on

registry.pfcomputing.internal/mncore-sdk/mncore-sdk-minimal:0.3.

How to Use MN-Core with MLSDK

In this document, we explain how to use MN-Core using MLSDK (Machine Learning Software Development Kit).

- What is MLSDK?

- MLSDK Images

- Launching an MLSDK Container

- How to use MLSDK API

- Processing Flow for Compiled Functions on MN-Core

- Advanced Data Transfer and Memory Management

- How to Port Your Workload to MN-Core 2

- Practical Examples Using MLSDK API

- Tools for Debugging and Profiling

What is MLSDK?

MLSDK is a software development kit that includes a compiler, runtime software stack, and documentation to enable using MN-Core from PyTorch. Although it is called “Machine Learning,” it can also be used for applications other than the machine learning field, as long as they are written with PyTorch.

Prerequisites

The followings are assumed in this document.

- You are a user of

- PFCP (Preferred Computing Platform)

- You have a basic knowledge of the followings:

- Pytorch

- Kubernetes

Notes on the Backward Compatibility

MLSDK is currently unstable, and there may be future updates that will not be backward compatible; Breaking changes are likely to be introduced.

If you want to use the same version of MLSDK, please modify the container image accordingly.

MLSDK Images

MLSDK is distributed as container images at Amazon ECR repository, registry.pfcomputing.internal/mncore-sdk. We provide two types of images as of Jan 2025: registry.pfcomputing.internal/mncore-sdk/mncore-sdk-minimal and registry.pfcomputing.internal/mncore-sdk/mncore-sdk-full. The former is a minimal image that contains only libraries, executables, and scripts that are mandatory to run MN-Core 1/2.

The latter is a fatter image that is built on the top of the minimal image, with the standard development tools (e.g., gcc, binutils, make, cmake, …) and the development environments (e.g., JupyterLab).

We provide two types of tag series for the minimal and full images. One tag type is “release”, which is a stable version of MLSDK, published roughly once every three months. The other tag type is “snapshot”, which delivers the latest development branch (that may not be mature) to users for trial purposes. The release tag follows the vYY.MM format (e.g., v24.12 for a Dec 2024 release), and the snapshot tag follows the snapshot_YYYYMMDD_githash (e.g., snapshot_20241201_0123456789abcdef). In addition to the aforementioned tags that immutably correspond to a unique image, we also provide latest and snapshot_latest tags to allow users to obtain the latest image for each series.

Launching an MLSDK Container

If you are new to PFCP and want to launch a kubernetes pod (a collection of running containers) with access to MN-Core 1/2 devices, the tutorial in the PFCP documentation is a good starting point.

Once a pod is properly configured, you can use the command gpfn3-smi list (see the following example) to display the connected MN-Core 2 devices within the pod.

The number 0 represents the device index of the MN-Core 2 device within the pod, and the string starting with mnc2 is the device ID within the pod.

If nothing is displayed, it indicates that there may be an issue with the pod configuration.

Please double-check the configuration and try again.

$ gpfn3-smi list

0: mnc2p28s0

How to use MLSDK API

From here, we explain how to run existing applications on MN-Core devices using the Python API (MLSDK API) included in MLSDK with several examples. You can also view the API reference.

First, we start with an example of running a pure function on MN-Core. Then, we demonstrate how to run a inference with a pretrained model. Finally, we introduce an example of model training.

Notes on Running Examples

You can locate all examples shown in this document in the MLSDK directory, where this README.md exists.

Also, you can run any command that starts with $ as is.

Notes on Environment Variable Settings

You need to set several environment variables to use the MLSDK API.

To set these variables, we recommend that you use the shell scripts /opt/pfn/pfcomp/codegen/build/codegen_preloads.sh and /opt/pfn/pfcomp/codegen/build/codegen_pythonpath.sh.

You are advised to write a shell script that loads these two files and then executes any given python script like the following:

Notes on Python venv Use

If you create a Python virtual environment with venv, do not forget to use the --system-site-packages option, which allows the virtual environment to access packages on the system site.

#! /bin/bash

set -eux -o pipefail

source /opt/pfn/pfcomp/codegen/build/codegen_preloads.sh

source /opt/pfn/pfcomp/codegen/build/codegen_pythonpath.sh

exec "$@"

In this tutorial, we refer the shell script as exec_with_env.sh.

The MLSDK directory can be found at /opt/pfn/pfcomp/codegen/MLSDK/ in the image. Move to the directory before following the examples below.

Example: Running a Pure Function on MN-Core

First, let’s go through an example of running a pure function, meaning the function has no state, on MN-Core.

Save the following code as add.py:

import torch

from mlsdk import CacheOptions, Context, MNDevice, storage

def run_add():

device = MNDevice("mncore2:auto")

context = Context(device)

Context.switch_context(context)

def add(input: dict[str, torch.Tensor]) -> dict[str, torch.Tensor]:

x = input["x"]

y = input["y"]

return {"out": x + y}

sample = {"x": torch.randn(3, 4), "y": torch.randn(3, 4)}

compiled_add = context.compile(

add,

sample,

storage.path("/tmp/add_two_tensors"),

options={"float_dtype": "float"},

cache_options=CacheOptions("/tmp/add_two_tensors_cache"),

)

result = compiled_add({"x": torch.ones(3, 4), "y": torch.ones(3, 4)})

result_on_cpu = result["out"].cpu()

print(f"{result_on_cpu=}")

assert torch.allclose(result_on_cpu, torch.ones(3, 4) * 2)

if __name__ == "__main__":

run_add()

And type the following command to run it! You should see the result of the computation done on MN-Core 2.

$ ./examples/exec_with_env.sh python3 examples/add.py

...

result_on_cpu=tensor([[2., 2., 2., 2.],

[2., 2., 2., 2.],

[2., 2., 2., 2.]])

The MLSDK API enables the use of MN-Core through a concept called “context.” A context is an object used to control and manage the MN-Core device. You can create a context like the following:

device = mlsdk.MNDevice("mncore2:auto")

context = Context(device)

In the code above, “mncore2:auto” specifies that the context will use a free MN-Core 2 device from all available devices.

You can also specify like “mncore2:0” to instruct which device to use explicitly.

The all available device indices can be listed by gpfn3-smi list.

To run a program on MN-Core, you need to compile a Python function into a function that runs on the MN-Core device using the compile method of the context.

It takes three mandatory args, some optional kwargs, and returns a compiled function.

add: user’s function to be compiled. It is assumed to have the type ofCallable[[dict[str, torch.Tensor]], dict[str, torch.Tensor]].sample: input example with the type ofdict[str, torch.Tensor]to annotate dtype and shape for the compiler.storage.path("/tmp/add_two_tensors"): directory path to store all compiling artifacts, including text logs and binary outputs.

The third argument is also referred to as “codegen directory” (i.e. “codegen_dir”). Files generated in “codegen directory” are so useful for debugging or profiling that we provide “codegen-dashboard” tool to visualize them. The detail of “codegen-dashboard” is described in the latter section.

The optional kwargs affect behaviors of the compiler.

options: generally called “compile options”. It is assumed to have the type ofdict[str, str].float_dtype: specifying which float dtype (double,float,mixed,half) to use as default. Themixedstands for Automatic Mixed Precision (AMP), and that’s the default setting of MLSDK.

cache_options: similar tooptions, but especially specifying the way to reuse previous compilations.

The returned value is a callable object (CompiledFuncion) which has a similar signature to the input function (add).

The difference is that types originally being torch.Tensor are processed as TensorLike (alias for Union[torch.Tensor, TensorProxy]).

TensorProxy represents torch.Tensor, but whether the actual data resides on the host or device is managed by the context.

The corresponding tensor gets accessable from the host by calling .cpu() on TensorProxy, though note that synchronization can occur.

Note that the returned function always expects inputs with the same shape.

In other words, the arguments passed to the function must always have the same keys, and the value of torch.Tensor that corresponds to each key must always have the same shape. Tensors with equal shapes but different values are of course acceptable.

Cache and reuse previous compilation results

When cache_options kwargs is specified, the exported ONNX graph of the input function and the compilation results are stored in the specified path (/tmp/add_two_tensors_cache).

Therefore you can port and reuse compiled functions with the caching feature. For example, you can compile a function with the cache_options argument and copy/move the cache directory to a different place, and then reuse the pre-compiled function by passing the cache_options argument so that it refers to the ported cache directory.

In addition to caching, MLSDK provides a more direct way to reuse a compiled function: the load_codegen_dir method. This method allows you to load an executable function directly from a codegen directory that was created in a previous compile call, completely bypassing the compilation step. For instance, after compiling the add function, you could load and run it in a separate process like this:

# In a different script or after the initial compilation

from mlsdk import Context, MNDevice, storage

import torch

device = MNDevice("mncore2:auto")

context = Context(device)

Context.switch_context(context)

# Load the previously compiled function

loaded_add = context.load_codegen_dir(storage.path("/tmp/add_two_tensors"))

# Now you can use it directly

result = loaded_add({"x": torch.ones(3, 4), "y": torch.ones(3, 4)})

result_on_cpu = result["out"].cpu()

print(f"Result from loaded function: {result_on_cpu=}")

assert torch.allclose(result_on_cpu, torch.ones(3, 4) * 2)

You can run the above code after the initial compilation to see that it produces the same result without needing to recompile.

$ ./examples/exec_with_env.sh python3 examples/load_codegen_dir.py

...

result_on_cpu=tensor([[2., 2., 2., 2.],

[2., 2., 2., 2.],

[2., 2., 2., 2.]])

Note that this method loads the artifacts without validation. It is the user’s responsibility to ensure that the contents of the codegen directory are valid and compatible with the execution environment.

Example: Running Inference with a Trained Model

Next, let’s go through an example of running inference with a trained model.

Save the following code as infer.py.

import torch

from mlsdk import Context, MNDevice, set_tensor_name_in_module, storage

def run_infer():

device = MNDevice("mncore2:auto")

context = Context(device)

Context.switch_context(context)

model = torch.nn.Linear(4, 4)

model.eval()

set_tensor_name_in_module(model, "model")

for p in model.parameters():

context.register_param(p)

for b in model.buffers():

context.register_buffer(b)

def infer(input: dict[str, torch.Tensor]) -> dict[str, torch.Tensor]:

x = input["x"]

y = model(x)

return {"out": y}

sample = {"x": torch.randn(4, 4)}

compiled_infer = context.compile(

infer,

sample,

storage.path("/tmp/infer"),

options={"float_dtype": "mixed"},

)

result = compiled_infer({"x": torch.ones(4, 4)})

result_on_cpu = result["out"].cpu()

print(result_on_cpu)

if __name__ == "__main__":

run_infer()

Then, running ./examples/exec_with_env.sh python3 examples/infer.py will perform inference using the pretrained model (model = torch.nn.Linear(4, 4)). Let’s do this.

$ ./examples/exec_with_env.sh python3 examples/infer.py

...

# Because the model weight is initialized randomly, you will see a different result.

tensor([[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574]])

In this example, we introduce new APIs in addition to the ones used in add.py.

set_tensor_name_in_module(model, "model")context.register_param(p)context.register_buffer(b)

The first one is relatively simple.

set_tensor_name_in_module sets names for all tensors in a given torch.nn.Model.

You can get the set name using get_tensor_name function.

context.register_param and context.register_buffer registers a given tensor with a given name.

After registration, you can synchronize registered tensors between PyTorch side and MN-Core side by calling synchronize.

The usage of synchronize is explained in the next section.

The options={"float_dtype": "mixed"} kwargs annotates the compiler to apply AMP computing.

For example, GEMM derived from torch.nn.Linear is executed in half precision, and some operations requiring high precision calculating are executed in float precision.

Since MLSDK is primarily designed for machine learning workloads, this mixed behavior is the default setting.

Example: Training a Model

Finally, let’s go through an example of training a model.

import torch

from mlsdk import (

Context,

MNCoreSGD,

MNDevice,

set_buffer_name_in_optimizer,

set_tensor_name_in_module,

storage,

)

def run_train():

class Model(torch.nn.Module):

def __init__(self):

super().__init__()

self.linear = torch.nn.Linear(10, 1)

def forward(self, *, x):

return {"y": self.linear(x)}

device = MNDevice("mncore2:auto")

context = Context(device)

Context.switch_context(context)

sample = {"x": torch.ones(1, 10)}

model = Model()

model.linear.weight.data.fill_(1.0)

model.linear.bias.data.fill_(1.0)

model.train()

set_tensor_name_in_module(model, "model")

for p in model.parameters():

context.register_param(p)

for b in model.buffers():

context.register_buffer(b)

optimizer = MNCoreSGD(model.parameters(), 0.1, 0.9, 0.0)

set_buffer_name_in_optimizer(optimizer, "optim0")

context.register_optimizer_buffers(optimizer)

def f(inp):

optimizer.zero_grad()

loss = torch.relu(model(**inp)["y"]).sum()

loss.backward() # type: ignore[no-untyped-call]

optimizer.step()

return {"loss": loss}

compiled_f = context.compile(

f,

sample,

storage.path("/tmp/train"),

)

print(f"Original {model.linear.bias=}")

for _ in range(10):

compiled_f(sample)

context.synchronize()

print(f"Optimized {model.linear.bias=}")

if __name__ == "__main__":

run_train()

Let’s run this example. You can see the model parameters are changed by the optimizer.

In this example, we use a new API synchronize().

It synchronizes tensors on MN-Core DRAM and PyTorch tensors.

After calling the function, you can check the optimized parameters in your program.

$ ./examples/exec_with_env.sh python3 examples/train.py

...

Original model.linear.bias=Parameter containing:

tensor([0.9000], requires_grad=True)

Optimized model.linear.bias=Parameter containing:

tensor([-2.0413], requires_grad=True)

Processing Flow for Compiled Functions on MN-Core

When you compile and execute functions on MN-Core using MLSDK, an efficient combination of asynchronous and synchronous processing is employed internally. Here, we’ll delve into the processing flow of how a compiled function operates.

Asynchronous Event Queue

When you invoke a compiled function, events for data input, actual computation execution, and retrieval of output results are each inserted into an internal queue.

These events strictly adhere to their invocation order and are processed sequentially on the MN-Core device. This allows multiple operations to be efficiently queued, maximizing the utilization of the device’s resources.

Synchronous Processing During Output Retrieval

Typically, a compiled function call is asynchronous, returning control to the caller immediately.

However, if you need to use the output results on the host (CPU) side—for example, by calling the .cpu() the system will wait until the corresponding event is completed.

This blocks the program’s execution until the necessary data has finished computing on MN-Core and is transferred to host memory.

Advanced Data Transfer and Memory Management

In the previous discussions, data transfer for inputs to compiled functions and retrieval of their results implicitly occurred.

MLSDK provides APIs to explicitly control asynchronous data transfer, enabling more advanced performance optimization and flexible memory management.

TensorProxy and Explicit Data Transfer

A TensorProxy is an object that represents a torch.Tensor located either in the MN-Core device’s memory or in host memory.

Tensors used as inputs to compiled functions or registered via context.register_param (and similar methods) are internally handled as TensorProxy objects.

TensorProxy provides the load_from method to asynchronously load data from a torch.Tensor on host memory.

TensorProxy.load_from(tensor: torch.Tensor, clone: bool = True) -> None

-

tensor: A torch.Tensor object residing in host memory. The data from this tensor will be transferred to the device memory pointed to by the TensorProxy.

-

clone: Defaults to True.

- True : The tensor’s data is copied, and this copy is placed into the transfer queue. This makes it safe to modify the original tensor after the

load_fromcall. - False: A direct reference to the tensor’s data is placed into the queue. This can reduce copy overhead, but modifying the original tensor before the transfer completes may lead to undefined behavior.

- True : The tensor’s data is copied, and this copy is placed into the transfer queue. This makes it safe to modify the original tensor after the

Obtaining Input Proxies with CompiledFunction.allocate_input_proxy()

The CompiledFunction.allocate_input_proxy method explicitly allocates DRAM buffers on the MN-Core device based on the expected input shapes and types of the compiled function, returning a dictionary of corresponding TensorProxy objects.

Obtaining TensorProxy for Registered Values with context.get_registered_value_proxy()

For PyTorch tensors registered via context.register_param or context.register_buffer, it’s also possible to explicitly obtain the TensorProxy that points to their device memory and use load_from to transfer data.

The context.get_registered_value_proxy method takes a torch.Tensor object previously registered with register_param or register_buffer as an argument, and returns its corresponding TensorProxy.

Example: TensorProxy and Explicit Data Transfer

import torch

from mlsdk import Context, MNDevice, set_tensor_name_in_module, storage

def run_explicit_data_transfer():

device = MNDevice("mncore2:auto")

context = Context(device)

Context.switch_context(context)

model = torch.nn.Linear(4, 4)

model.eval()

set_tensor_name_in_module(model, "model")

for p in model.parameters():

context.register_param(p)

for b in model.buffers():

context.register_buffer(b)

def infer(input: dict[str, torch.Tensor]) -> dict[str, torch.Tensor]:

x = input["x"]

y = model(x)

return {"out": y}

sample = {"x": torch.randn(4, 4)}

compiled_infer = context.compile(

infer,

sample,

storage.path("/tmp/proxy_transfer"),

)

input_proxies_allocated = compiled_infer.allocate_input_proxy()

input_proxies_allocated["x"].load_from(torch.ones(4, 4), clone=False)

for model_param in model.parameters():

model_param_proxy = context.get_registered_value_proxy(model_param)

model_param_proxy.load_from(model_param, clone=False)

result = compiled_infer(input_proxies_allocated)

result_on_cpu = result["out"].cpu()

print(result_on_cpu)

if __name__ == "__main__":

run_explicit_data_transfer()

./examples/exec_with_env.sh python3 examples/explicit_data_transfer_api.py

# Because the model weight is initialized randomly, you will see a different result.

tensor([[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574],

[-0.4468, -0.2559, 0.0939, 0.8574]])

How to Port Your Workload to MN-Core 2

Running Your Workload Using pfvm:cpu

Before running your workload on MN-Core 2, we highly recommend running it on pfvm:cpu first.

With this backend, you can ensure that your code can be converted to ONNX accurately.

For more details, please check Backends other than mncore2:auto.

We, the MN-Core compiler team, believe that users can go through this process without specific knowledge of MN-Core.

If the function passed to compile only contains static shapes, the process should be successful.

Note on Static Shape Requirements

When compiling functions for execution on the MN-Core 2 backend, it is important to note that the functions passed to the compiler must only contain static shapes. Static shapes refer to the fixed dimensions of tensors at compile-time and do not involve dynamic graphs such as if statements or loops. In particular, the following restrictions apply to the functions:

- Tensors must have fixed dimensions at compile-time.

- The shape of each tensor must be known and constant throughout the function.

- Control flow constructs such as if statements, loops, and recursion are not supported in functions.

If the dynamic constructs in the function rely on runtime information or user input to determine loop counts or other control flow decisions, the compiled functions will always follow the same decisions based on the input shapes at the time of trace, regardless of any changes to the user input or runtime context.

Replacing pfvm:cpu with (emu2 or mncore2:auto)

After running your workload on pfvm:cpu, let’s compile your code for MN-Core 2.

If you have MN-Core 2 in your pod, you can use mncore2:auto.

However, the emulator backend of MN-Core 2, emu2, is sufficient for checking if your code can run on MN-Core 2.

During this process, you may encounter several compiler errors. When your code fails to compile, one option is to adjust the input size. For example, adjusting the batch size or the image size can be effective. Also, it is recommended to use a batch size that is a power of 2.

Practical Examples Using MLSDK API

Here are some examples using MLSDK API that are included in the MLSDK container image.

MNIST

The script for training MNIST is available at mnist.py.

$ ./examples/exec_with_env.sh python3 examples/mnist.py

...

epoch 8, loss 0.14200307160075182

epoch 9, iter 0, loss 0.3466796875

epoch 9, iter 100, loss 0.12501551845286152

epoch 9, iter 200, loss 0.11559456260643193

epoch 9, iter 300, loss 0.12726582522408106

epoch 9, iter 400, loss 0.12854511630802673

epoch 9, iter 500, loss 0.13125214200771737

epoch 9, iter 600, loss 0.1303801415565605

epoch 9, iter 700, loss 0.1311912290039824

epoch 9, iter 800, loss 0.13359734881087937

epoch 9, iter 900, loss 0.13450224351935858

epoch 9, loss 0.13449914363812235

...

eval acc 0.9567

timm Model Inference

timm is a library that contains many computer vision models.

You can run a timm model on MN-Core 2 using run_timm.py. This script classifies an image and prints the result. Please use run_timm.sh to run the Python script. This shell script installs timm in venv environment and then runs the inference.

$ ./examples/run_timm.sh --model_name resnet50.a1h_in1k --batch_size 16

...

MNCore2 top-5 classes:

- espresso (967)

- cup (968)

- chocolate sauce, chocolate syrup (960)

- consomme (925)

- eggnog (969)

Torch top-5 classes:

- espresso (967)

- cup (968)

- chocolate sauce, chocolate syrup (960)

- eggnog (969)

- consomme (925)

You can use other timm models.

$ ./examples/run_timm.sh --model_name mobilenetv3_small_050.lamb_in1k --batch_size 16

...

MNCore2 top-5 classes:

- cup (968)

- trifle (927)

- face powder (551)

- ice cream, icecream (928)

- coffee mug (504)

Torch top-5 classes:

- cup (968)

- trifle (927)

- ice cream, icecream (928)

- face powder (551)

- coffee mug (504)

Image Generation from Text Prompt

You can get a beautiful image of Fujisan with the following command. We need to skip VAE decoder compilation for now.

$ ./examples/run_stable_diffusion.sh --skip_vae_decoder_compilation --prompt "Fujisan" --device mncore2:auto

...

Output image saved at /tmp/mlsdk_stable_diffusion_out/output.png

In case out of memory error happens, you can set the number of threads used for the compilation by the option num_compiler_threads, e.g. --num_compiler_threads 32.

Large Language Model (LLM) Inference

The script for running Llama 1B inference is available at llm_infer.py.

You need to install the transformers library and set the environment variable MNCORE_USE_EXTERNAL_DATA_FORMAT=1 to run the script.

run_llm_infer.sh does this setting in addition to what exec_with_env.sh does.

Currently, the compilation of the prefill phase requires specifying some environment variables. Therefore, we split the example into two parts, one for the compilation of the prefill phase, and the other for the decoding phase. This will be addressed in later releases.

Let’s run the inference. The prefill phase runs on MN-Core, and the decoding phase runs on CPU.

You can specify the prompt by additionally passing arguments like --prompt 'What is the meaning of life?'.

Note that the --num_compiler_threads option is also available here.

$ MNCORE_USE_LEGACY_ONNX_EXPORTER=1 MNCORE_USE_EXTERNAL_DATA_FORMAT=1 CODEGEN_TIME_SLICE_SCATTERED_INDEXING_BCAST=1 CODEGEN_OP_DEF=Gather=GatherBcast ./examples/run_llm_infer.sh --compile_prefill --prepare_attention_mask_on_cpu --device mncore2:auto

...

=========== Generated with compilation ==========

</s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s><s> <|system|>

You are a friendly chatbot who is an expert on MN-Core.</s>

<|user|>

The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens. With some proper optimization, we can achieve this within a span of "just" 90 days using 16 A100-40G GPUs 🚀🚀. The training has started on 2023-09-01.</s>

<|assistant|>

Yes, that's correct. The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens using 16 A100-40G GPUs. The training has started on 2023-09

========== Generated with model.generate ==========

<s> <|system|>

You are a friendly chatbot who is an expert on MN-Core.</s>

<|user|>

The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens. With some proper optimization, we can achieve this within a span of "just" 90 days using 16 A100-40G GPUs 🚀🚀. The training has started on 2023-09-01.</s>

<|assistant|>

Yes, that's correct. The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens using 16 A100-40G GPUs. The training has started on 2023-09

Generated outputs matched.

Let’s do the opposite: prefill on CPU, and decode on MN-Core.

$ MNCORE_USE_LEGACY_ONNX_EXPORTER=1 MNCORE_USE_EXTERNAL_DATA_FORMAT=1 ./examples/run_llm_infer.sh --compile_decode --prepare_attention_mask_on_cpu --device mncore2:auto

...

=========== Generated with compilation ==========

</s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s></s><s> <|system|>

You are a friendly chatbot who is an expert on MN-Core.</s>

<|user|>

The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens. With some proper optimization, we can achieve this within a span of "just" 90 days using 16 A100-40G GPUs 🚀🚀. The training has started on 2023-09-01.</s>

<|assistant|>

Yes, that's correct. The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens using 16 A100-40G GPUs. The training has started on 2023-09

========== Generated with model.generate ==========

<s> <|system|>

You are a friendly chatbot who is an expert on MN-Core.</s>

<|user|>

The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens. With some proper optimization, we can achieve this within a span of "just" 90 days using 16 A100-40G GPUs 🚀🚀. The training has started on 2023-09-01.</s>

<|assistant|>

Yes, that's correct. The TinyLlama project aims to pretrain a 1.1B Llama model on 3 trillion tokens using 16 A100-40G GPUs. The training has started on 2023-09

Generated outputs matched.

After the compilation and execution, the above script performs a comparison of the generated sequence against the generation API of transformers.

The results may not match exactly, depending on the model weights and prompt. However, they are unlikely to be completely different.

Tools for Debugging and Profiling

When working with MN-Core, you may often need to debug and profile complex scenarios. In this section, we will introduce some useful tools for debugging.

Backends Other than mncore2:auto

pfvm:cpu Backend

The compile function converts the passed function into an internal representation called ONNX before executing it.

Occasionally, there may be errors in this conversion from the function to ONNX or ONNX to MN-Core machine instructions.

To detect such cases, the pfvm:cpu backend comes in handy.

The pfvm:cpu backend allows you to run ONNX models on CPU without compiling it for MN-Core.

You can use it by specifying "pfvm:cpu" instead of "mncore2:auto" when creating the context.

device = mlsdk.MNDevice("pfvm:cpu")

context = Context(device)

Context.switch_context(context)

Programs that does not work correctly with "pfvm:cpu" will not work with "mncore2:auto" either.

Therefore, this functionality should be the first thing to try when a program does not work with MN-Core.

emu2 Backend

Even if you do not have an MN-Core 2 device installed on your system, you can still test your program’s behavior on MN-Core 2 using an emulator.

The "emu2" backend is specifically designed for this purpose.

This is essentially an emulator for MN-Core 2 that allows your program to run in a simulated environment just like a real MN-Core 2 device would.

By using this backend, you can ensure that your code will work as expected before running it on the real device.

Just like as other backends, you can use it with the following code.

device = mlsdk.MNDevice("emu2")

context = Context(device)

Context.switch_context(context)

codegen-dashboard

serve Subcommand

codegen-dashboard is a web-based dashboard for the MN-Core compiler. It allows users to view ONNX files, logs, error messages and more.

The executable is named codegen-dashboard-external, and located under the /opt/pfn/pfcomp/codegen/build/codegen-dashboard/ directory.

To start codegen-dashboard-external, execute the following command and open the indicated URL in your web browser.

$ /opt/pfn/pfcomp/codegen/build/codegen-dashboard/codegen-dashboard-external serve /tmp/add_two_tensors/add

Started to serve at http://localhost:8327

Please note that this document assumes that you are working inside a Kubernetes pod, hence http://localhost:8327/ is inaccessible from your local machine. To access the page, enable port forwarding using the command below:

$ kubectl port-forward <POD_NAME> 8327:8327

The codegen-dashboard serve <codegen_dir> [flags] command requires the location of the MN-Core compiler output directory, termed as codegen_dir.

In Example: Running a Pure Function on the MN-Core, the directory is generated to /tmp/add_two_tensors. codegen-dashboard can also accept optional flags such as --port <port number>, --host <hostname>, etc. For the comprehensive list of available flags, refer to codegen-dashboard serve --help.

genhtml Subcommand

codegen-dashboard provides a genhtml <codegen_dir> [flags] subcommand.

This command generates HTML files inside the specified codegen_dir, which can be accessed via file URIs.

The genhtml subcommand offers a subset of the features available in the serve command, but is very handy when sharing with others.

$ /opt/pfn/pfcomp/codegen/build/codegen-dashboard/codegen-dashboard-external genhtml /tmp/add_two_tensors/add

Writing /tmp/add_two_tensors/add/model.onnx.html ...

Writing /tmp/add_two_tensors/add/logviewer.html ...

Writing /tmp/add_two_tensors/add/index.html ...

Use Perfetto for Profiling

You can profile your code with Perfetto, which loads traced data from a local file and shows the detailed analysis in an interactive way. The module mncore.utils.perfetto_trace provides an easy way to generate files that can be loaded from Perfetto UI.

To profile your code, first import trace_scope function from the module:

from mlsdk import trace_scope

Then enclose the entrypoint of your code with:

with trace_scope("trace-file-name.pb"):

your_entry_point() # e.g. main() or run() or whatever

And that’s all! The trace file will be saved to "trace-file-name.pb" when you run the code.

Here is a patch to enable perfetto tracing for add.py, which is already introduced in this tutorial.

Apply this patch and save to add_trace.py:

--- add.py

+++ add_trace.py

@@ -1,5 +1,5 @@

import torch

-from mlsdk import CacheOptions, Context, MNDevice, storage

+from mlsdk import CacheOptions, Context, MNDevice, storage, trace_scope

def run_add():

@@ -28,4 +28,5 @@

if __name__ == "__main__":

- run_add()

+ with trace_scope("trace.pb"):

+ run_add()

Type the following command to check the result:

$ ./exec_with_env.sh python3 add_trace.py

...

result_on_cpu=tensor([[2., 2., 2., 2.],

[2., 2., 2., 2.],

[2., 2., 2., 2.]])

[908.203] perfetto.cc:53691 Tracing session 1 ended, total sessions:0

$ ls *.pb

trace.pb

Then you can access Perfetto UI and open the file (trace.pb in this example) to check the result.

Note

This document is based on

registry.pfcomputing.internal/mncore-sdk/mncore-sdk-minimal:0.3.

MLSDK documentation

class mlsdk.Context(device: MNDevice)

compile(function: Callable[[Dict[str, Tensor]], Dict[str, Tensor]], inputs: Mapping[str, Tensor | TensorProxy], codegen_dir: Path, *, options: Dict[str, Any] | None = None, cache_options: CacheOptions | None = None, num_compiler_threads: int | None = None, quiet: bool = True, exit_after_generate_codegen_dir: bool = False, optimizers: List[Optimizer] | None = None, export_kwargs: Dict[str, Any] | None = None, training: bool = True, initialize: bool | None = True, optimizer_spec: List[OptimizerSpecParamGroup] | None = None, optional_options: Set[str] | None = None, group: ProcessGroup | None = None, predefined_symbols: Dict[str, MNDeviceBuffer] | None = None) → CompiledFunction

Compile a Python callable to a function that can be executed on the device.

- Parameters:

-

function – The Python callable to compile.

-

inputs – Sample inputs to the function.

-

codegen_dir – The directory to store intermediate and generated files.

-

options –

You can specify compile options here. Since there are so many options, we provide predefined options in the preset_options directory. If you use the MLSDK image, there should be O0.json - O4.json in the /opt/pfn/pfcomp/codegen/preset_options directory. Options from a file with a higher number will perform more advanced optimizations, at the cost of the compilation time. Among all available options, setting float_dtype is also crucial to prevent unintended precision degradation. The MLSDK defaults to mixed precision operations (mixed), GEMM operations using half precision. To avoid this, set float_dtype to float. This argument also accept Among all available options, setting float_dtype is also crucial to prevent unintended precision degradation. This option controls which floating-point type to assign for torch.float32 tensors, and takes the following values:

- mixed (default): in/out of GEMM are half, otherwise are float.

- half, float, double: assign the type for all such tensors.

You can specify these compile options like the following: You can specify these compile options like the following:

context.compile( ... options={ "option_json": "preset_options/O4.json", "float_dtype": "float", }, ) -

cache_options – Options for caching. See CacheOptions for details.

-

num_compiler_threads – The number of threads to use for compilation. If None, the number of threads will automatically be determined.

-

quiet – If True, suppress output from the compiler.

-

exit_after_generate_codegen_dir – For internal use only. If True, exit after generating the codegen directory. This is useful for decomposed layers test.

-

optimizers – For internal use only. A list of PyTorch optimizers to use for training.

-

export_kwargs – For internal use only. kwargs related to exporting the model to ONNX.

-

training – For internal use only. If True, the function is used for training.

-

optimizer_spec – For internal use only. The optimizer spec to use for training.

-

initialize – For internal use only. TODO (akirakawata): Add description.

-

optional_options – For internal use only. TODO (akirakawata): Add description.

-

group – For internal use only. TODO (akirakawata): Add description.

-

predefined_symbols – For internal use only. TODO (akirakawata): Add description.

-

get_registered_value_proxy(value: Tensor) → TensorProxy

- Get the TensorProxy for the given value if it is registered in the context.

- param value: The torch.Tensor to get the proxy for.

- return: The TensorProxy for the given value.

load_codegen_dir(codegen_dir: Path) → CompiledFunction

Load a function that can be executed on the device from codegen_dir without validation.

- Parameters: codegen_dir – The directory to load compile results files.

NOTE

This method will fail if the required compiled artifact, model.app.zst, is not found within the codegen_dir. Be aware that the returned function is strict; it requires an input dictionary with the exact same keys (variable names) and tensor shapes as the input used during the original compilation.

register_buffer(buffer: Tensor) → None

Registers a buffer in the context.

NOTE

Before calling this method, you must set the name of the buffer using set_tensor_name_in_module or set_tensor_name.

register_optimizer_buffers(optimizer: MNCoreOptimizer) → None

Registers optimizer buffers in the context.

NOTE

Before calling this method, you must set the name of the buffer using set_buffer_name_in_optimizer or set_tensor_name.

register_param(param: Parameter) → None

Registers a parameter in the context.

NOTE

Before calling this method, you must set the name of the parameter using set_tensor_name_in_module or set_tensor_name.

synchronize() → None

Synchronizes the context by moving tensors to the torch framework and marks the context for initialization.

This method performs the following steps:

- Calls the synchronize() method of the device associated with the context.

- Iterates over all tensor names in the registry and moves each tensor to the torch framework.

NOTE

Different from sync torch.cuda.synchronize(), which only wait for all kernels in all streams on a CUDA device to complete. This function also moves all tensors in the context’s registry from the device to the host.

class mlsdk.CompiledFunction(context: Context, code_block: _CompiledFunction, *, output_signature: ValueSignature | None = None)

allocate_input_proxy() → Dict[str, TensorProxy]

- Allocate input proxies for the function.

- return: A dictionary mapping input names to their corresponding TensorProxy objects.

class mlsdk.TensorProxy(context: Context, codegen_data: TensorProxyCodegenData, *, is_input: bool = False)

load_from(value: Tensor | TensorProxy, *, clone: bool = True) → None

- Load data from a torch.Tensor or another TensorProxy to this TensorProxy.

- param value: The source tensor to copy data from.

- param clone: If True and value is a torch.Tensor, it will be cloned before copying, enabling the source tensor to be modified without affecting this TensorProxy.

class mlsdk.CacheOptions(cache_dir_str: str, *, enable_app_cache: bool = True, enable_onnx_cache: bool = False, enable_codegen_cache: bool = False, enable_gpfn2obj_cache: bool = False)

__init__(cache_dir_str: str, *, enable_app_cache: bool = True, enable_onnx_cache: bool = False, enable_codegen_cache: bool = False, enable_gpfn2obj_cache: bool = False) → None

The options for specifying the cache directory and controlling cache behavior.

- Parameters:

- cache_dir_str – A path string of the root directory to store cache.

- enable_app_cache – If True, cache compiled GPFNApp files from ONNX files. GPFNApp is the binary format of MN-Core compiler uses.

- enable_onnx_cache – If True, cache exported ONNXs from the given function.

- enable_codegen_cache – If True, cache the codegen compilation. This option is mainly for developers.

- enable_gpfn2obj_cache – If True, cache the GPFN object data. This option is mainly for developers.

class mlsdk.MNCoreOptimizer(params: Iterator[Parameter], defaults: Dict[str, Any])

zero_grad(set_to_none: bool = True) → None

Clear the gradient of the parameters.

- Parameters: set_to_none (bool) – If True, the gradients will be set to None instead of zero.

class mlsdk.MNCoreSGD(params: Iterator[Parameter], lr: float | Tensor = 0.001, momentum: float = 0, dampening: float = 0, weight_decay: float | Tensor = 0, nesterov: bool = False, *, maximize: bool = False, foreach: bool | None = None, differentiable: bool = False, fused: bool | None = None)

step(closure=None) → None

Perform a single optimization step to update parameter.

- Args:

-

- closure (Callable): A closure that reevaluates the model and

- returns the loss. Optional for most optimizers.

class mlsdk.MNCoreAdam(params: Iterator[Parameter], lr: float | Tensor = 0.001, betas: tuple[float | Tensor, float | Tensor] = (0.9, 0.999), eps: float = 1e-08, weight_decay: float = 0, amsgrad: bool = False, *, foreach: bool | None = None, maximize: bool = False, capturable: bool = False, differentiable: bool = False, fused: bool | None = None, decoupled_weight_decay: bool = False, chainer_use_torch: bool = True)

step(closure=None) → None

Perform a single optimization step to update parameter.

- Args:

-

- closure (Callable): A closure that reevaluates the model and

- returns the loss. Optional for most optimizers.

class mlsdk.MNCoreAdamW(params: Iterator[Parameter], lr: float | Tensor = 0.001, betas: tuple[float | Tensor, float | Tensor] = (0.9, 0.999), eps: float = 1e-08, weight_decay: float = 0.01, amsgrad: bool = False, *, maximize: bool = False, foreach: bool | None = None, capturable: bool = False, differentiable: bool = False, fused: bool | None = None)

step(closure=None) → None

Perform a single optimization step to update parameter.

- Args:

-

- closure (Callable): A closure that reevaluates the model and

- returns the loss. Optional for most optimizers.

class mlsdk.MNCoreLRScheduler(scheduler: LRScheduler, context: Context | None)

step() → None

Perform a step.

mlsdk.set_buffer_name_in_optimizer(optimizer: MNCoreOptimizer, name: str) → None

Set the buffer names in the optimizer.

This function sets the names of the tensors in the optimizer (i.e. buffers) according to the optimizer’s name, so that ONNX exporter (FX2ONNX) can distinguish them later. You need to call this function before registering the optimizer buffers to the context.

- Parameters:

- optimizer – The optimizer to set buffer names.

- name – The name of the optimizer.

mlsdk.get_tensor_name(tensor: Tensor) → str | None

Get the name of the tensor.

This function returns the name of the tensor set by

set_tensor_name_in_module or set_buffer_name_in_optimizer.

- Parameters: tensor – The tensor to get the name of.

- Returns: The name of the tensor.

mlsdk.set_tensor_name_in_module(module: Module, module_name: str | None) → None

Set the tensor names in the module.

This function sets the names of the tensor in the module (i.e. parameters and buffers such as BN stats), so that ONNX exporter (FX2ONNX) can distinguish them later. You need to call this function before registering the module parameters and buffers to the context.

- Parameters:

- module – The module to set tensor names.

- module_name – The name of the module.

mlsdk.path(target: str) → Path

mlsdk.trace_scope(output_filename: str | Path | None, ignore_if_traced: bool = False) → Iterator[None]

PFCP のロール

PFCP で利用可能なロールと、各ロールで利用できる操作を説明します。

ロールの種類

PFCP には、 組織管理者 と 一般ユーザ の 2 種類のロールがあります。

組織管理者

- 所属組織のすべての操作が可能です。

- Kubernetes クラスタのルートネームスペースとすべてのサブネームスペースに対して、Kubernetes 標準ロール の

admin相当の権限を持ちます。

一般ユーザ

- 所属組織の Kubernetes クラスタを利用できます。

- Kubernetes クラスタのルートネームスペースに対して、Kubernetes 標準ロール の

edit相当の権限を持ちます。 - Kubernetes クラスタのサブネームスペースに対しては、初期状態では権限を持ちません。RoleBinding による権限の付与が必要です。

- ユーザ管理操作はできません。

利用可能な操作一覧

クラスタ利用

| 操作 | 組織管理者 | 一般ユーザ |

|---|---|---|

| kubectl のセットアップ | o | o |

| [Kubernetes リソースの操作] | ||

| ルートネームスペース: Kubernetes 標準ロールの admin 相当1 | o | |

| ルートネームスペース: Kubernetes 標準ロールの edit 相当2 | o | o |

| サブネームスペース: Kubernetes 標準ロールの admin 相当1 | o | |

| サブネームスペース: RoleBinding により個別に権限付与 | N/A | o3 |

| サブネームスペースの作成・削除 | o | |

| リソースクオータの確認 | o | o |

ユーザ管理

| 操作 | 組織管理者 | 一般ユーザ |

|---|---|---|

| ユーザの招待・削除 | o | |

| ユーザの権限変更 | o | |

| ユーザグループの作成・削除 | o | |

| ユーザグループへのユーザの追加・削除 | o | |

| ユーザグループと外部認証基盤との連携作成・削除 | o |

-

Kubernetes 標準の

adminとは一部異なり、一部リソースの権限削除および PFCP で利用しているカスタムリソースの権限追加がされています。org-adminという ClusterRole で定義されています。権限の詳細は、各リソースごとのドキュメントページをご確認ください。 ↩ ↩2 -

org-adminと同様、Kubernetes 標準のeditとは一部異なります。org-editという ClusterRole で定義されています。権限の詳細は、各リソースごとのドキュメントページをご確認ください。 ↩ -

RoleBinding で紐づける Role により、付与される権限が異なります。RoleBinding の詳細は、権限設定(RBAC) をご確認ください。 ↩

組織のユーザを管理する

PFCP では、組織管理者が組織に属するユーザの管理をおこないます。

PFCP におけるユーザの管理には以下の 2 つの方法があります。

- ポータル上でのユーザの直接管理

- 外部認証基盤との連携によるグループ単位の管理

ユーザの管理

ご利用の組織へ、直接ユーザの招待、ロール変更、削除をおこなう方法を説明します。

Note

直接招待を行うアカウントは、Google の個人アカウントもしくは Google Workspace アカウントのみ使用できます。

Warning

ユーザに対するロールやユーザグループの変更操作が、既存のログイン済みユーザのセッションに反映されるまで、時間がかかることがあります。 再ログインやブラウザクッキーの消去を試してください。

ユーザを招待する

- ポータルの ユーザ管理ページ にアクセスし、招待メールを送る ボタンをクリックします。

- 招待したいユーザの Eメール と ロール を入力し、招待メールを送る ボタンをクリックします。

- 送信した招待は、受諾待ち一覧 に表示されます。招待メールが受理されると、一覧から消えます。

- 招待が期限切れになってしまった場合は再送してください。

ユーザのロールを変更する

- ポータルの ユーザ管理ページ にアクセスし、ユーザ一覧 を表示します。

- ロールを変更したいユーザを選択し、ロールを変更します。

- ログインしているユーザ自身のロールは変更できません。

ユーザを組織から削除する

- ポータルの ユーザ管理ページ にアクセスし、 ユーザ一覧 を表示します。

- 削除したいユーザを選択し、組織メンバーから削除します。

- 削除したユーザを元に戻したい場合は、再度招待が必要です。

- ログインしているユーザ自身は削除できません。

ユーザグループの管理

組織に属するユーザをグループにまとめることができます。 グループ単位での管理により、ネームスペースに対する権限管理を効率化します。 また、外部認証基盤とユーザグループとを連携させることにより、ご利用の組織のアカウントを連携させることが可能です。

権限管理については、権限設定(RBAC) をご確認ください。

ユーザグループへの所属

ユーザはユーザグループに 2 通りの方法で所属できます。どちらの方法でも、ユーザはグループに所属しているものと扱われます。

- ユーザグループへの直接の所属

- ポータル上で、ユーザをユーザグループに追加します。

- ユーザグループと外部認証基盤のグループの連携

- ユーザグループを外部認証基盤のグループと連携させることで、外部認証基盤のグループに所属するユーザを自動的にユーザグループに追加します。

ユーザグループを作成する

- ポータルの ユーザグループ管理ページ にアクセスし、新規作成 ボタンをクリックします。

- フォームを入力し、作成 ボタンをクリックします。

ユーザグループを削除する

- ポータルの ユーザグループ管理ページ にアクセスします。

- 削除したいグループを選択し、削除 ボタンをクリックします。

ユーザグループにユーザを追加する

- ポータルの ユーザグループ管理ページ にアクセスし、編集したいグループを選択します。

- メンバー追加 セクションで追加したいユーザを選択し、追加 ボタンをクリックします。

- 追加するユーザは、まず組織に招待し受諾されている必要があります。

Note

グループへの所属が Kubernetes クラスタへの接続情報に反映されるまでには、最大 1 時間かかります。

ユーザグループからユーザを削除する

- ポータルの ユーザグループ管理ページ にアクセスし、編集したいグループを選択します。

- メンバー セクションで削除したいユーザを選択し、選択したメンバーを外す ボタンをクリックします。

ユーザグループと外部認証基盤との連携を作成する

- ポータルの 外部認証連携ページ にアクセスします。

- 外部認証基盤のグループ ID と PFCP のグループ名 を入力し、グループ連携を追加 ボタンをクリックします。

- PFCP のグループは先に作成しておく必要があります。

ユーザグループと外部認証基盤との連携を削除する

- ポータルの 外部認証連携ページ にアクセスします。

- 削除したい連携を選択し、選択したグループ連携を削除する ボタンをクリックします。

PFCP ポータルにログインする

PFCP では、Kubernetes クラスタに接続するための認証情報の取得や、各種管理機能を扱うためのポータルを提供しています。

初回ログイン

Note

このセクションでは、メールアドレスを使用する標準的なログイン方法を説明します。 組織によって異なるログイン方法となることがあります。詳細は、組織管理者にお問い合わせください。

- 組織管理者にユーザの招待を依頼します。

- 招待メールを受領したら、メール本文の ACCEPT INVITATION ボタンをクリックします。

- 招待内容の確認画面が表示されます。組織名と招待メールの送信者が正しいことを確認し、 続ける をクリックします。

- 招待メールを受領したメールアドレスを使用してログインします。

- ログイン後、組織名の入力画面が表示されるので、招待された組織名を入力します。

- ログイン状態の再確認が行われたあと、ポータルに自動で遷移します。

2回目以降のログイン

- ポータル にアクセスします。

- 組織名の入力画面が表示されるので、ご利用の組織名を入力します。

- 登録されたメールアドレスを使用してログインします。

クラスタに接続する

このページでは、Kubernetes クラスタに接続する方法を説明します。

クラスタの操作に使用するコマンドラインツールのインストール

Kubernetes のコマンドラインツールである kubectl ツールを用いて、Kubernetes クラスタに接続します。

kubectl ツールのインストールは、公式ドキュメントを参考に実施します。

Kubernetesクラスタの接続情報を設定

- ポータルのkubectlのセットアップ にアクセスします。

- クラスタ名 のドロップダウンから使用したいクラスタを選択します。

- 認証情報の取得 をクリックし、出力されたコマンドをコピーしてターミナルで実行します。

Note

複数の環境からクラスタに接続する

複数の環境からクラスタに接続する場合は、環境ごとに複数回 認証情報の取得 をクリックしてそれぞれ異なるコマンドを生成して使用してください。

同じ認証情報を複数の環境で使いまわした場合、認証情報が無効化されて次のようなエラーと共にクラスタの操作に失敗します。

failed to refresh token: oauth2: "invalid_grant" "Unknown or invalid refresh token."認証情報が無効化された場合は改めて認証情報を取得し直して再設定する必要があります。

接続確認

kubectl auth whoami を実行し、Username にご自身のメールアドレス、Groups にご利用の組織名のグループが表示されることを確認します。

$ kubectl auth whoami

ATTRIBUTE VALUE

Username oidc:<ご利用の組織名>/<ご利用のメールアドレス>

Groups [oidc:<ご利用の組織名> system:authenticated]

Kubernetes の基礎を学ぶ

PFCP はオープンソースのコンテナオーケストレーションプラットフォームである Kubernetes をベースに構成されています。このサイトのドキュメントは Kubernetes の基本的なコンセプトや用語を理解していることが前提になっています。まだ Kubernetes に慣れていない方は、ここで Kubernetes の基礎を確認してください。また、公式サイトや書籍を通じて Kubernetes についてさらに深く知ることで、PFCP をより効果的に利用できるようになります。

Kubernetes の概要

Kubernetes は、Cloud Native Computing Foundation(CNCF)にホストされたオープンソースのコンテナオーケストレーションプラットフォームです。コンテナ化されたアプリケーションの展開、スケーリング、可用性の管理を自動化するためのツールで、この分野の標準として広く採用されています。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Note

PFCP は Kubernetes をベースとして深層学習・AI ワークロード向けのクラウドサービスとして構成されています。提供するクラスタはマネージドで、ユーザがクラスタ自体を運用する必要がありません。

クラスタとノード

クラスタはワークロードを実行・管理するためのマシン群の集合体です。ユーザからみると 1 つのまとまった計算リソースとして扱えます。

ノードはクラスタを構成する 1 つのマシンで、その実体は一般的な仮想マシンや物理マシンです。

Kubernetes はユーザからワークロードのデプロイが指示されると、ワークロード定義に記述された CPU やメモリ、MN-Core といったデバイスの要求数を確認し、適切なノードにワークロードをスケジュール、実行します。

Note

PFCP ではユーザのワークロードを実行するためのノードのことを「計算ノード」と呼びます。

Namespace

Kubernetes Namespace は 1 つのクラスタを論理的に分割するための機能です。 Kubernetes ではリソースの名前が Namespace 内でユニークである必要があります。 ステージングや本番などの環境を分割したり、複数のチームやプロジェクトから使用する場合に Namespace を使うことでリソースの管理が容易になります。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Note

一般に Kubernetes Namespace の管理にはクラスタ全体の管理者権限が必要ですが、PFCP では Kubernetes カスタムアドオンを使用して組織管理者が Namespace を管理できます。

Pod

Kubernetes ではワークロードを Pod という 1 つ以上のコンテナで構成します。Pod は Kubernetes におけるデプロイ可能な最小単位です。 1 つの Pod に含まれるコンテナは必ず同一のノード上で実行され、同じネットワークとストレージを共有しながら動作します。

詳細は、Kubernetes の公式ドキュメントを参照ください。

コンテナとコンテナイメージ

コンテナはシステムの他の部分とは分離して一連のプロセスを実行する技術です。コンテナはホストや他のプロセスから切り離されるため、環境依存による問題を引き起こしにくく、どの環境でも同じように実行できます。

コンテナを実行するために必要なコードやライブラリ、ランタイムはコンテナイメージと呼ばれるパッケージに含める必要があります。 コンテナイメージはコンテナイメージレジストリと呼ばれるサービスに保存され、配信されます。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Note

PFCP の専用コンテナイメージレジストリは、MN-Core の使用に必要なファイルやソフトウェアを含むコンテナイメージを提供しており、すぐに MN-Core の使用を開始できます。

Note

PFCP ではユーザ自身がビルドしたコンテナイメージをクラスタで使用するためのコンテナイメージレジストリを提供していません。 外部のコンテナイメージレジストリサービスをご利用ください。

Pod を管理する上位のリソース: Deployment、StatefulSet、Job、CronJob…

Kubernetes は Pod を管理するより上位のリソースタイプを提供し、様々な種類のワークロードをサポートします。

- Deployment: クラスタのノード間で分散された複数の Pod レプリカを実行します。失敗した Pod や応答しなくなった Pod は自動的に置き換えられるため、サービスを可用性高く運用する用途に向いています。

- StatefulSet: 各 Pod レプリカに一意の ID を保持して実行します。ステートフルなアプリケーションの実行に役立ちます。

- Job: 1 つ以上の Pod レプリカを作成して指定された数の Pod が正常に終了するまで、Pod の作成と実行を再試行し続けます。ワンショットの学習を行う用途に向いています。

- CronJob: Linux

cronのように指定のスケジュールに基づき Kubernetes Job を作成します。

Warning

上位リソースを使わずにユーザにより直接作成された Pod(Bare Pod)はノードの障害などが理由で停止された場合に自動的に他のノードで再実行されません。 基本的に直接 Pod を作成することは避け、上位のリソースを使用してください。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Note

PFCP では深層学習・AI ワークロードの実行に便利な Kubernetes 組み込みではないカスタムのリソースも提供しています。カスタムのリソースについては、本ユーザガイドをご参照ください。

Service

Service は一連の Pod に固定されたネットワークエンドポイントを提供します。 Pod は実行するたびに異なる IP アドレスが自動先に割り当てられるため、直接 Pod に対しては安定してアクセスできません。

加えて、Kubernetes はクラスタ内部のアドレス解決用に組み込みの DNS を提供し、Service の名前を使用したサービスディスカバリ機能を提供します。Service の名前を使用して安定してワークロードにアクセスできます。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Ingress

Ingress はクラスタ外から Kubernetes Service に対しての HTTP/HTTPS アクセスを提供します。ホスト名やパスに応じたリクエストの振り分けが可能です。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Note

PFCP では、Ingress を使用してサービスにインターネットから安全に公開できます。 ワークロードをウェブ API として公開する または ワークロードをウェブアプリとして公開する を参照してください。

永続ストレージ

実行中の Pod に保存されたデータは Pod の停止とともに失われます。 Pod の存続期間を超えてデータを保持する必要がある場合には、PersistentVolumeClaim を使用して永続ストレージをプロビジョニングし、Pod にマウントして使用できます。

詳細は、Kubernetes の公式ドキュメントを参照ください。

マニフェストファイル

クラスタ上に作成・管理したいリソースの状態(構成)を記述した YAML または JSON 形式のファイルをマニフェストファイルと呼びます。一般に YAML 形式で記述されます。

Kubernetes ではクラスタに対してワークロードをデプロイするにはコマンドラインツールなどから命令的に作成・更新する方法と、マニフェストファイルを使用して宣言的に作成・更新する方法の 2 つがあります。 命令的な方法は一時的に操作する場合に素早く行える利点があります。一方で再現性が低いため、多くの場合に望ましい状態をファイルとして管理できるマニフェストファイルを使用した宣言的な方法の使用を推奨します。

詳細は、Kubernetes の公式ドキュメントを参照ください。

Namespace でクラスタを論理的に分割する

Kubernetes では、Namespace リソースを作ることで複数の作業空間を構築し、各作業空間ごとに独立したリソース管理ができます。 検証・本番環境のように権限やネットワーク接続性の要件が異なる環境を運用したい場合や、複数のチームで利用する場合に有用です。

PFCP では、Namespace リソースの作成機能を提供しています。 ただし、PFCP の Kubernetes クラスタはマルチテナント型で構成されているため、Namespace リソースの作成に関して一般の Kubernetes クラスタとは異なる以下の制約があります。

Warning

ネームスペースの制約

- 各組織には、ルートネームスペースとして 1 つの Namespace リソースが提供されます。

- 追加の Namespace リソースは、このルートネームスペースに従属するサブネームスペース1として作成します。

- ルートネームスペースのリソース名は、

org-<組織名>です。- サブネームスペースのリソース名は、

org-<組織名>--が接頭辞として付きます。- ルートネームスペースは、PFCP の全クラスタで事前に作成されます。削除できません。

- サブネームスペースは、PFCP の各クラスタごとに個別に作成します。削除可能です。

- kubectl などを利用して直接 Namespace リソースを作成することはできません。2

- サブネームスペースに従属するサブネームスペース(孫ネームスペース)を作成することはできません。

以下では、サブネームスペースを管理する方法を説明します。

サブネームスペースの作成

以下の手順で、サブネームスペースを作成します。

- ポータルのネームスペースにアクセスします。

- ネームスペースの作成 画面を開きます。

- クラスタ名、ネームスペース名、説明を入力します(説明は任意項目です)。

- 組織内の他の Namespace からの通信を許可しない場合は、 オプション2にチェックを入れてください。

- 作成 ボタンをクリックすると、サブネームスペースが作成されます。

作成したサブネームスペースは、通常の Namespace リソースとして使用できます。

# サブネームスペース `org-<組織名>--foo` を作成した場合

$ kubectl get all -n org-<組織名>--foo

No resources found in org-<組織名>--foo namespace.

組織管理者は、作成したサブネームスペースに対して org-admin Role の権限が自動で付与されます。

一般ユーザは、サブネームスペースに対して自動での権限付与がされないため、RoleBinding を作成して権限を付与する必要があります。

RoleBinding の詳細は、権限設定をご確認ください。

サブネームスペースの変更

- ポータルのネームスペースにアクセスします。

- 変更したいサブネームスペースの変更画面を開き、設定を修正します。クラスタ名、ネームスペース名は変更できません。

- 更新 ボタンをクリックすると、サブネームスペースが変更されます。

Note

ルートネームスペースの変更はできません。

サブネームスペースの削除

- ポータルのネームスペースにアクセスします。

- 削除したい Namespace を選択し、削除します。

Warning

サブネームスペースを削除すると、Namespace リソース内で作成された全リソースが削除されます。

Note

ルートネームスペースの削除はできません。

参考: コマンドラインツールでサブネームスペースを操作する

サブネームスペースの機能は、Hierarchical Namespaceの SubnamespaceAnchor カスタムリソースで実現しています。 kubectl-hnsプラグインを導入すると、サブネームスペースの操作をターミナルから行えます。

サブネームスペースの作成

# org-<組織名>--foo サブネームスペース を作成する

$ kubectl hns create org-<組織名>--foo -n org-<組織名>

Successfully created "org-<組織名>--foo" subnamespace anchor in "org-<組織名>" namespace

階層構造の閲覧

$ kubectl hns tree org-<組織名>

org-<組織名>

└── [s] org-<組織名>--foo

Namespaceの削除

$ kubectl delete subnamespaceanchor org-<組織名>--foo -n org-<組織名>

-

サブネームスペース機能を提供するために、Hierarchical Namespaceを採用しています。 ↩

-

Hierarchical Namespace のカスタムリソースである SubnamespaceAnchor を使用すれば、サブネームスペースとして Namespace リソースを作成できます。 ↩ ↩2

ユーザのクラスタアクセス権限を管理する

PFCP では、Kubernetes における Role/RoleBinding を用いた Role Based Access Control(RBAC)が利用できます。 RoleBinding を作成することで、Role に定義された権限をユーザやグループに付与できます。

Note

以下を読み進める前に PFCP のロール を確認し、PFCP で利用可能なロールについて把握してください。

PFCP で標準提供するロールとグループ

以下の 3 つの ClusterRole1 が利用できます。

org-view- ユーザのワークロードを閲覧するために必要な権限を有します。

org-editorg-viewの権限に加えて、ユーザのワークロードを実行するために必要な権限を有します。

org-adminorg-editの権限に加えて、Role/RoleBinding 操作などの管理者権限を有します。

Tip

各 ClusterRole は Kubernetes 標準の

view/edit/adminClusterRole を基として一部リソースの権限削除および PFCP で利用しているカスタムリソースの権限追加がされています。 具体的にどのリソースに対してどの操作が許可されているかについては下記コマンドで参照できます。$ kubectl get clusterrole org-view org-edit org-admin -o yaml

また、以下の 2 つのグループが標準で提供されています。

org-<組織名>(例:org-pfn)- 組織管理者と一般ユーザの両方がこのグループに所属します。

- ルートネームスペースに対してのみ

org-editRole が与えられます。サブネームスペースに対しては Role が付与されません。

org-<組織名>/admin(例:org-pfn/admin)- 組織管理者が所属するグループです。

- ルートネームスペースおよびすべてのサブネームスペースに対して、

org-adminClusterRole が与えられます。

ルートネームスペースは、組織に属するすべてのユーザが org-edit 以上の権限を有しているため、初期設定のままご利用いただけます2。

新規に作成したサブネームスペースについては、一般ユーザは権限をもちません。一般ユーザに権限を付与するには、RoleBinding を作成します。

RoleBinding の作成

RoleBinding は、以下の 2 通りで作成できます。

- グループに対する RoleBinding の作成

- ユーザに対する RoleBinding の作成

サブネームスペースに対して、グループ・ユーザのそれぞれに org-edit の ClusterRole2を付与する方法を説明します。

グループに対する RoleBinding の作成

すべてのユーザに対し、サブネームスペース(org-<組織名>--foo)への権限を付与するには、以下の RoleBinding を作成します。

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: org-edit

namespace: org-<組織名>--foo

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: org-edit

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: Group

name: oidc:org-<組織名>

また、組織のユーザを管理する で作成したユーザグループへ権限を付与できます。

ユーザグループ(ops)に対し、サブネームスペース(org-<組織名>--foo)への権限を付与するには、以下の RoleBinding を作成します。

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: org-edit-ops # name は任意です

namespace: org-<組織名>--foo

roleRef: